🎞 影视制作的数字化

🎞 混合电影长片《金刚:骷髅岛》(Kong: Skull Island,2017)

导演:乔丹·沃格-罗伯茨(Jordan Vogt-Roberts);制作公司:Legendary Pictures,Warner Bros. Pictures,腾讯影业;首映时间:2017 年 2 月 28 日(伦敦)。

-

在运动捕捉已经盛行之时,该片却没有完全依赖这种技术,手K关键帧动画扮演了更主要的角色。

- 原因是该片的金刚在形体设计上和人类差距较大,而且它有很多和其它数字动物战斗的场景,这导致真人运动捕捉只能有限地使用。

- 金刚身高达110英尺,是 2005 年版的 4 倍。工业光魔团队打破传统大猩猩四足行走设定,参考人类与尼安德特人的骨骼结构,通过手K关键帧动画实现直立步态,同时保留灵长类肌肉运动特征。

- 动画总监斯科特·本扎(Scott Benza)负责了这部电影的所有动画制作。为避免体型过大导致动作迟缓,特效团队在特写镜头中加快肢体运动速度(如手掌下落速度达 140 公里 / 小时),全景镜头则通过动态模糊和环境破坏效果强化冲击力,使观众产生 “速度与重量并存” 的视觉错觉。

-

CG毛发技术突破:

- 金刚拥有1900万根毛发:采用工业光魔自研的 HairCraft 工具,首次实现单根毛发的物理模拟 —— 每根毛发可独立受风、水、火等环境因素影响,并能吸附泥土、树叶等杂物。例如,金刚在雨中战斗时,毛发会因湿度变化呈现不同质感。

- 材质分层渲染:将毛发分为底层绒毛、中层粗毛、表层护毛三层,分别赋予不同颜色、卷曲度和透光性,最终通过光线追踪技术实现自然光泽。

- 复杂生物的物理模拟与生态互动:

- 骷髅巨蜥的动态平衡:为双足行走的骷髅巨蜥设计尾巴辅助系统,通过跟踪鹿的运动数据,使尾巴既能保持平衡,又能作为武器缠绕绞杀敌人。

- 巨型章鱼的流体力学模拟:为 9 条触须的章鱼开发专用算法,实时计算每根触须的运动轨迹与水流阻力,解决无骨骼生物的运动连贯性问题。

- 生态系统的细节呈现:在金刚体表添加动态飞虫群,模拟其作为岛屿生态核心的生物特征;巨型水牛的牛角运动速度达 80 公里 / 小时,需与水面涟漪效果精确同步。

- 虚实结合的拍摄与特效融合:

- 三大洲实地取景:在越南下龙湾、夏威夷欧胡岛、澳大利亚黄金海岸拍摄半年,获取真实地貌数据。例如,越南长安名胜区的喀斯特地貌被直接用于骷髅岛主场景,后期通过 CG 扩展成巨型岛屿。

- 动态分镜与预演技术:使用 Previs(前期视觉预览)和 Postvis(后期视觉预览)工具,在拍摄前用低精度模型模拟直升机坠毁、金刚战斗等复杂场景,优化机位与动作设计。例如,工业光魔制作了近 200 个生物模型,测试不同光照条件下的肌肉纹理变化。

- 动态光照匹配:实地拍摄时记录越南丛林的自然光参数(如色温、阴影角度),后期用 CG 精确还原在金刚毛发、皮肤表面的光影变化,实现 “真实环境中生长的巨兽” 效果。

- 音效与视觉的协同创新:

- 空间音频系统:采用杜比全景声(Dolby Atmos)与 Auro 11.1 技术,将金刚的咆哮声定位在影院顶部,模拟高空声源;直升机螺旋桨声从观众四周环绕而过,增强沉浸感。

- 其他制作信息:

- 工业光魔团队总共为《骷髅岛》制作了1048个镜头,约占影片50分钟的银幕时长。

- 单帧平均渲染时间约 12 小时,较 2005 年版《金刚》提升 40% 效率。

- 工业光魔在 SIGGRAPH 2017 大会发布技术论文《Kong: Skull Island – The Making of a Modern Monster》。

- 详细披露生物动画、毛发渲染等核心技术细节。

- 获第 90 届奥斯卡最佳视觉效果提名🎗️。

🎞 电影长片《银翼杀手2049》(Blade Runner 2049,2017)

导演:丹尼斯·维尔诺娃(Denis Villeneuve);制作公司:Alcon Entertainment等;全球首映:2017 年 10 月 3 日(洛杉矶)。

- 运动图像(MPC)为该片制作了演员肖恩·杨(Sean Young)的数字替身,以展示她30多年前的外貌。

- 该公司在接受 fxguide 采访时透露他们有一个名为“影子实验室”的技术研发部门,开发包括数字人类在内的各种新技术。

-

Montgomery J. MPC Replicating Rachael in Blade Runner 2049[EB/OL]. (2017)[2022-12-15]. https://www.fxguide.com/fxfeatured/mpc-replicating-rachael-in-blade-runner-2049/

- 全片采用IMAX 1.9:1 比例拍摄,比普通影院多出 26% 画面内容,增强沉浸感。

- 使用杜比视界(Dolby Vision) HDR 技术,对比度达 100 万:1,精准还原雨夜霓虹、橙色雾霾等细节。导演维尔诺娃称其 “释放了光影的全部潜力”。

🎞 新软件:

Storyboarder

- 免费故事板软件,

- 由Wonder Unit开发。

🎞 新软件:

Boords

- Animade 开发了基于网页的故事板工具,

- 无需安装,功能简洁。

♾ 新软件:

ZIVA VFX

- Ziva Dynamics 开发的数字角色创造工具,

- 提供直观的工具包、可复制物理效果、模拟肌肉、脂肪皮肤等软组织材料,可与“MAYA”兼容。

♾ 新软件:

Sprout

-

Sony Pictures Imageworks开发了基于“MAYA”的专有工具,

- 用于手动修饰大量高分辨率资产的数字环境,如树木、植物和岩石。

♾ 新软件:

Paint 3D

- 光栅图形和3D建模应用程序,

- 由微软开发,结合了此前Microsoft Paint和3D Builder应用程序的功能。

🪄 新软件:

3D-Coat

- 3D数字雕刻、贴图绘制、渲染软件,

- 由 Pilgway 开发,官网未提供初版发布时间,但至少不晚于2017年。

🪄 新软件:

Snappers

- Snappers 系统开发的自适应绑定软件,

- 基于面部动作编码系统(FACS)模拟真实的面部肌肉,与多数主流游戏引擎和动画软件包兼容。

🪄 新软件:

Simple Animation

- 基于云的虚拟动画和视觉效果远程协作工作平台,

- 由 Summus 推出。

🪄 动画技术的艺术跨界

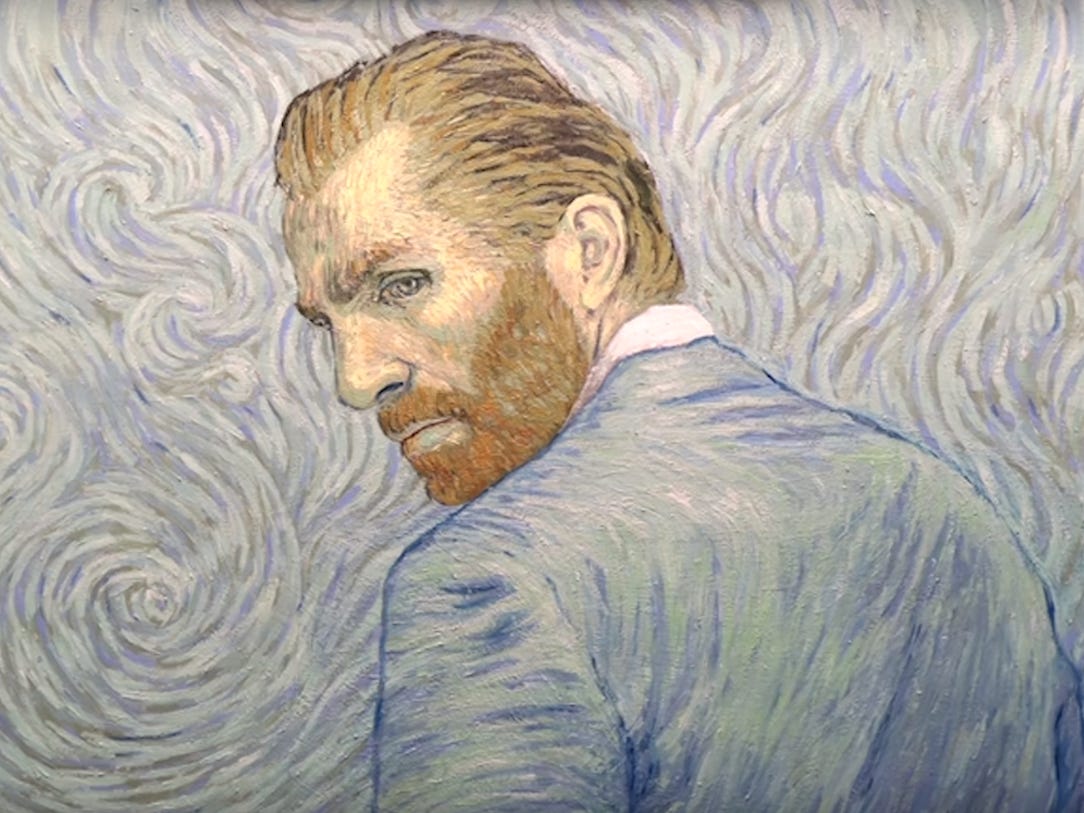

🎞 动画长片《至爱梵高》(Loving Vincent,2017)

导演:多洛塔·科别拉(Dorota Kobiela),休·韦尔什曼(Hugh Welchman)

-

一部由65000幅手绘油画组成的动画长片。

- 125名来自世界各地的艺术家花了6年时间才完成了这一壮举。

- 由于艺术家通常会在拍摄完照片后就在同一幅油画上继续作画,最后只有1000幅油画被保存下来。

- 该片使用了一种特殊的转描方法:

- 真人演员在绿幕上拍摄,然后把它们与梵高的画作合成,再投影到画布上,艺术家可参照其绘画。

🎞 动画长片《寻梦环游记》(Coco,2017)

导演:李·昂克里奇(Lee Unkrich)

- 一部基于墨西哥文化背景的动画长片,繁复细节和色彩斑斓是该片的基石,据说它的资产文件数量高达10亿。

- 大型复杂场景的灯光照明是其中一个大难题。

-

🔬皮克斯的研发团队开发了新的“点云照明系统”,又再集成到另一个新的“照明选择系统”中。

- 分层、多角度烘培等额外方法也被用于降低渲染时间,花了近半年的时间才让复杂镜头的名义渲染时间从1000小时降至50小时每帧。

-

- 传统的制作方法难以应对该片庞大的服饰工作量。

-

🔬拜伦·巴什福斯(Byron Bashforth)等开发了一种自动程序,为该片中数千件衣服制作缝线、刺绣和色彩的材质贴图。

-

《自动化手工工艺:Coco项目数千件服装的着色技术》Byron Bashforth, Fernando de Goes, Jacob Kuenzel, Jake Merrell, and Athena Xenakis. 2018. Automating the handmade: shading thousands of garments for Coco. In ACM SIGGRAPH 2018 Talks (SIGGRAPH ’18). Association for Computing Machinery, New York, NY, USA, Article 21, 1–2. https://doi.org/10.1145/3214745.3214792

-

-

🔬为该片改进的布料碰撞检测和响应解算,被整合到皮克斯的核心模拟器“FIZT”。

- 并在布莱恩·费(Brian Fee)执导的《赛车总动员3》(Cars 3,2017)中开始引入3D实体,实现艺术指导和物理模拟的结合。

🎞 动画短片《特工327:理发店行动》( Agent 327: Operation Barbershop,2017)

导演:贾尔蒂·贾尔马松(Hjalti Hjalmarsson),科林·利维(Colin Levy);制作公司:Blender工作室

- 展示了免费开源动画软件“Blender”用于制作院线级数字动画的可能性。

- 2010年代后期,免费开源软件的发展越发蓬勃,但标榜3A级的专业制作公司依然青睐昂贵的商业软件,其原因包括技术上和商业上的考量。

🎞 动画短片《丑陋》(Ugly,2017)

导演:尼基塔·迪亚库尔(Nikita Diakur),雷比尔·伊斯特曼(Redbear Easterman)

- 一直以来,3D数字动画都致力于表现所谓“对”的东西,无论是拟真还是拟绘,而《丑陋》展示了如何拥抱“错误”😈,失败的动力模拟、穿插的模型、不同寻常的造型和失控的镜头等,以展示数字动画的另外一面。

- 这恰恰是数字动画技术足够先进的证明,就像学徒在需要证明自己有能力的阶段害怕展露错误,而大师们却乐于展示不完美之美,随后在网络上风行一时的“三年动画”也是类似案例。

-

正因为动画技术已经可以很“正确”,所谓的“错误”便显得别有一番趣味。

🎞 动画长片《养家之人》(The Breadwinner,2017)

导演:Nora Twomey

- “故事世界”片段使用2.5D动画技术模拟传统剪切动画,并为其带来更细腻的灯光、色彩和深度感变化。

🔬 圣地亚哥·蒙特斯多卡(Santiago Montesdeoca) 发布了其“3D直接风格化管道”。

- 通过直接在3D模型上绘制水彩画效果并实时预览,在欧特克的3D软件“MAYA”中实现。

🎨 新硬件:

Cintiq Pro

-

WACOM推出🥇首款32英寸4K平板电脑,

- 搭配Wacom Pro Pen 2手绘笔。

🎨 新硬件:

Canvas

- 戴尔推出27英寸平板显示器,

- 支持20点多点触控和手写笔绘画技术。

🪄 新软件:

Midas Creature

-

Midas Touch Interactive 开发了为2D图像添加次级运动的动画软件,

- 基于骨骼系统和物理模拟,可作为一个独立程序,也可为游戏引擎提供插件。

🎮 实时动画技术的广泛应用

🎮🎞 动画连续剧《地灵曲》(2017)

导演:常磊

-

🥇第一部使用游戏引擎(虚幻4)制作的动画连续剧。

- 尽管与同时期的预渲染动画相比有差距,但游戏引擎用于长篇动画连续剧制作的未来已经明朗。

- 该片也使用了量子动力公司的表情捕捉系统。

🎮🎞 Epic Games在其虚幻引擎中加入了名为“Composure”的插件。

- 允许数字内容与实拍内容实时结合,从而进一步将其游戏引擎链接到影视动画制作领域。

🎞🎮 引擎动画《亚当:3》(Adam: Episode 3,2017)

导演:尼尔·布鲁姆坎普(Neill Blomkamp);制作公司:Oats Studios,Unity Technologies;首映时间:2017 年 11 月 30 日(油管)

-

演示了“Unity引擎”在制作照片真实感数字人类角色动画方面的能力。

- 全流程实时制作:

- 采用 Unity 2017 的延迟渲染路径(Deferred Rendering),实现复杂场景的多光源实时计算(单帧支持超过 200 个动态光源)。

- 取消传统渲染农场,所有镜头在实时环境中完成打光、材质调整和特效合成。

- HDR 管线的系统化应用:

- 使用 ACES(Academy Color Encoding System)作为色彩管理标准,支持 10 位色深和 4000 尼特峰值亮度,真实还原末日场景的高对比度光影(如金属锈蚀的漫反射与强光反射)。

- 结合屏幕空间反射(SSR)和环境光遮蔽(SSAO),在实时渲染中实现照片级材质质感,例如角色服装的布料纤维和皮肤毛孔细节。

- 高精度3D模型重建:

- 采用摄影测量(Photogrammetry)技术扫描真实演员和实体衣服,生成高精度3D角色模型,结合 Blend Shape、Marvelous Designer等软件制作动画。

- 实地拍摄加州废弃矿井的无人机 LiDAR 数据,导入 Unity 生成高分辨率地形网格(精度达 0.1 米),叠加手工雕刻的岩石纹理, “真实地理数据 + 艺术化加工” 的场景构建。

- 次表面散射(SSS)的实时渲染:

- 开发自定义着色器,通过多散射半径参数化,在延迟渲染管线中实现皮肤透光效果,例如角色在逆光下的耳轮泛红。

- 引入模板缓冲区(Stencil Buffer)标记 SSS 区域,优化计算效率,确保在 GTX 1060 显卡上仍能保持 30 FPS,证明实时渲染已具备替代传统离线渲染的潜力。

- 体积雾效的物理化模拟:

- 基于 Unity 的 Compute Shader 开发体积雾系统,实时计算光线在气溶胶中的散射(Mie 散射)和吸收(Beer-Lambert 定律),实现光束穿透尘埃的丁达尔效应。

- 雾效参数与环境光强动态关联,例如当角色打开手电筒时,雾效密度自动降低以增强可见性。

- 2017 年 10 月 3 日,作为 Unity 开发者大会(Unite Austin)的技术演示作品进行闭门预展。

- 开源授权:影片资产(角色、场景、Timeline 文件)通过 Unity Asset Store 开放下载,供教育和非商业用途使用。

🎮 《生化危机7》(バイオハザード7 レジデント イービル,2017)

开发:Capcom;平台:Windows、PlayStation 4、Xbox One等。

-

Capcom 为该游戏开发了新一代游戏引擎“RE Engine”,

- 也是专门为8世代游戏机开发的专有引擎,在图形处理和角色动作方面有出色表现。

🔬 美国Pinscreen公司在SIGGRAPH年会上展示了其新的3DCG人脸技术:

- 仅从一张人脸图像创建其3DCG替身。

- 基于人工智能、使用精确密集3D人脸网格、通过网络镜头便可进行运动捕捉并实时生成动画。

- 该公司随后发布了一系列面部运动捕捉、自动数字替身生成、AI换面等软件和应用。

🔬 英伟达、苏黎世联邦理工学院和迪士尼研究所带来了各自新研发的实时流体模拟技术演示。

🔬 美国 OpenAI 公司训练的“泰坦2机器人”在不到一个月的时间里学会了“玩”游戏,

- 并在对战游戏《泰坦2》(DotA 2,2013)的1对1比赛中成功击败被誉为世界最佳选手的人类对手丹尼尔·伊斯胡汀(Danil Ishutin)。

- 这预示着人类生活可能发生某种巨变,也意味着动画技术即将迎来新的“伙伴”👾。

🔬 基于神经网络训练和深度学习的自动唇型同步被高度关注,

- 多位研究者分享了他们研究成果,其后续发展在很大程度上释放了动画师在唇型同步方面的工作,甚至可以推出多语言版本的唇型。

- 《广义语音动画的深度学习方法》提出基于滑动窗口的深度学习框架。

- 通过音素序列直接生成高保真语音动画,解决了传统方法依赖手工调整与跨语言泛化难题,其核心创新在于将协同发音效应建模为局部非线性映射,并通过端到端训练实现实时生成与多场景适配。

-

Sarah Taylor, Taehwan Kim, Yisong Yue, Moshe Mahler, James Krahe, Anastasio Garcia Rodriguez, Jessica Hodgins, and Iain Matthews. 2017. A deep learning approach for generalized speech animation. ACM Trans. Graph. 36, 4, Article 93 (August 2017), 11 pages. https://doi.org/10.1145/3072959.3073699

- 《音频驱动的面部动画联合端到端学习姿态与情感》提出基于端到端深度学习的音频驱动面部动画生成方法。

- 通过联合建模面部姿态与情感状态,实现实时低延迟的口型同步与表情控制,并支持跨说话者泛化,为虚拟角色交互提供高效解决方案。

-

Tero Karras, Timo Aila, Samuli Laine, Antti Herva, and Jaakko Lehtinen. 2017. Audio-driven facial animation by joint end-to-end learning of pose and emotion. ACM Trans. Graph. 36, 4, Article 94 (August 2017), 12 pages. https://doi.org/10.1145/3072959.3073658

- 《基于语音的3D面部动画端到端学习方法》提出基于语音频谱的端到端深度学习框架,

- 通过联合建模语音内容与情感状态,实现实时3D面部动画生成,其核心创新在于从语音中自动学习情感强度并动态调整面部动作单元,为虚拟角色赋予自然的情感表达能力。

-

Hai Xuan Pham, Yuting Wang, and Vladimir Pavlovic. 2018. End-to-end Learning for 3D Facial Animation from Speech. In Proceedings of the 20th ACM International Conference on Multimodal Interaction (ICMI ’18). Association for Computing Machinery, New York, NY, USA, 361–365. https://doi.org/10.1145/3242969.3243017

- 《广义语音动画的深度学习方法》提出基于滑动窗口的深度学习框架。

🔬 各大软/硬件开发商继续加速引入VR、AR技术。

新硬件:

IPhone10

- 苹果推出新一代智能手机,

-

正式开启了基于智能手机的增强现实(AR)交互时代🎊,

- 其深度镜头也激发了一系列使用手机作为运动捕捉工具的探索。

🎮🎞 新软件:

Mocha VR

- 鲍里斯效果(Boris FX)为其著名跟踪插件“Mocha”开发了VR插件,

-

🥇第一款针对 After Effects 、Media Composer 等后期合成软件的360°素材优化插件。

🎮🎞 新软件:

PoseVR

-

迪士尼动画工作室也开发了虚拟现实角色动画制作系统,

- 致力于让艺术家在更少干扰的环境中专注工作。

🎮🎞 新软件:

Lytro Volume Tracer

-

莱特洛(Lytro)公司开发了基于光场技术的光线追踪器,

- 用于渲染3D场景的光场效果,

- 为混合现实(MR)、扩展现实(XR)等体验提供更好的光场匹配体验,也可用于任何数字和实拍内容“合成”项目。

🎮🎞 新软件:

Storyboard VR

-

Artefact 开发了用于交互动画项目原型制作的免费故事版软件。

🎮 新软件:

Spaces VR

-

在VR环境中查看,移动,编辑3D模型,

- 由 Strata 开发。

🎮 新硬件:

Switch

-

任天堂推出首款8世代家用+掌上游戏机,

- 手柄可与屏幕分离,主机既可通过自带屏幕显示游戏画面(最大分辨率1280×720像素),也可以通过基座连接到其他显示屏(最大分辨率1920×1080像素)。

- 它一方面体现了计算机硬件技术的进步,但也预示了专用的掌上游戏机正在走向他们的时代终点 👻。

🎮 新硬件:

Xbox One X

- 微软推出的8世代家用游戏机,

- 支持4K流媒体和游戏,至2020年停产。

新软件:

Unigine

-

跨平台实时3D引擎,

- 展示了用于交互式环境的实时光线追踪技术。

🎮 新软件:

Construct

-

Scirra 公司开发了基于HTML5的2D游戏引擎,

- 提供可视化拖放功能,面向无编程背景的普通游戏开发者。

🎮 Visual Novel Maker

- 视觉小说引擎,由Degica开发。

.jpg)